Успокойтесь, ChatGPT на самом деле не искусственный интеллект

30 марта 2023 г.Алан Тьюринг, одна из основоположников информатики, был одержим искусственным интеллектом в конце своей трагически короткой жизни. На самом деле настолько, что он придумал неофициальный тест для определения того, когда компьютер можно назвать действительно разумным, как человек, который мы теперь называем тестом Тьюринга.

Тест довольно простой. Пусть кто-то общается с компьютером, и если он не может сказать, что разговаривает с компьютером, то есть неотличим от человека другой человек, то компьютер поднялся бы до уровня человека. интеллект.

Ну, Кажется, ChatGPT успешно проходит этот тест. На самом деле, это не просто сдача теста Тьюринга, это сдача экзаменов в медицинском и юридическом колледжах и, по крайней мере, выполнение домашнего задания за каждого ребенка в Соединенных Штатах.

И если вы не знаете, что такое ChatGPT, это может показаться ошеломляющим. Настолько, что люди начинают проецировать на ChatGPT и генеративный ИИ в целом те качества и человеческие характеристики, которых у него на самом деле нет.

Обычно это не было бы слишком большой проблемой. Люди все время неправильно понимают самые разные вещи, но, поскольку ИИ, подобные ChatGPT, получат более широкое распространение только в ближайшие месяцы, люди будут вкладывать в них силы, которых у них на самом деле нет, и если они будут неправильно использованы в соответствии с этим предположением. , они могут быть гораздо более вредными, чем полезными.

Что такое состязательный генеративный ИИ?

Основополагающая технология, лежащая в основе ChatGPT, Stable Diffusion и всех других ИИ, которые производят изображения, тесты, музыку и многое другое, известна как генеративно-состязательная сеть (GAN). Я не буду здесь слишком углубляться, но, по сути, GAN — это две программные системы, работающие вместе. Один производит выходные данные, генератор, а другой определяет, являются ли эти данные действительными или нет, классификатор.

Генератор и классификатор в GAN перемещаются слово за словом или пиксель за пикселем и, по сути, борются за достижение консенсуса, прежде чем перейти к следующему сегменту. Шаг за шагом (буквально) GAN производит результат, который очень точно воспроизводит то, что может сделать человек, творчески.

Генератор полагается на непристойное количество входных данных, на которых он «обучается» для получения выходных данных, а классификатор полагается на свои собственные входные данные, чтобы определить, имеет ли смысл то, что произвел генератор. Это может быть или не быть тем, как человеческий интеллект «создает» новые вещи — неврологи все еще пытаются это понять — но во многих отношениях вы можете отличить дерево по плодам, которые оно приносит, поэтому оно должно достигать человеческого уровня. интеллект. Верно? Хорошо...

ChatGPT проходит тест Тьюринга, но имеет ли это значение?

Когда Тьюринг придумал свой тест на искусственный интеллект, он имел в виду беседу с рациональным субъектом, так что вы не могли бы сказать, что разговариваете с машиной. В этом подразумевается идея о том, что машина понимает то, что вы говорите. Не распознавание ключевых слов и создание вероятностного ответа на длинный набор ключевых слов, а понимание.

Для Тьюринга общение с машиной до такой степени, что она была неотличима от человеческого отраженного интеллекта, потому что создание обширного хранилища слов с разным весом, присвоенным каждому в зависимости от слов, которые предшествуют ему в предложении, просто не было чем-то, что кто-либо мог бы сделать. задумано в то время.

Математика, необходимая для такого рода вычислений, на машинах, которым требуется целый день для выполнения вычислений, которые самый дешевый смартфон может сделать за наносекунды, выглядела бы столь же неразрешимой, как подсчет количества атомов во Вселенной. В то время это даже не учитывалось.

К сожалению, Тьюринг не прожил достаточно долго, чтобы предвидеть рост науки о данных и чат-ботов или даже интегральной схемы, на которой работают современные компьютеры. Еще до ChatGPT чат-боты были на пути к прохождению теста Тьюринга в общепринятом понимании, и любой, кто использует чат-бота для общения со своим банком, может вам сказать. Но Тьюринг не увидел бы в чат-боте искусственный разум, равный человеческому.

Чат-бот — это одноцелевой инструмент, а не интеллект. Интеллект человеческого уровня требует способности выходить за рамки параметров, которые его разработчики установили для себя, по собственной воле. ChatGPT необычайно хорошо имитирует образцы человеческого языка, но и попугай тоже, и никто не может утверждать, что попугай понимает значение слов, которые он повторяет.

Прохождение ChatGPT теста Тьюринга не означает, что ChatGPT так же умен, как человек. Это явно не так. Все это означает, что тест Тьюринга не является действительным тестом искусственного интеллекта, как мы думали.

ChatGPT не может научить себя ничему, он может учиться только тому, чему его направляют люди

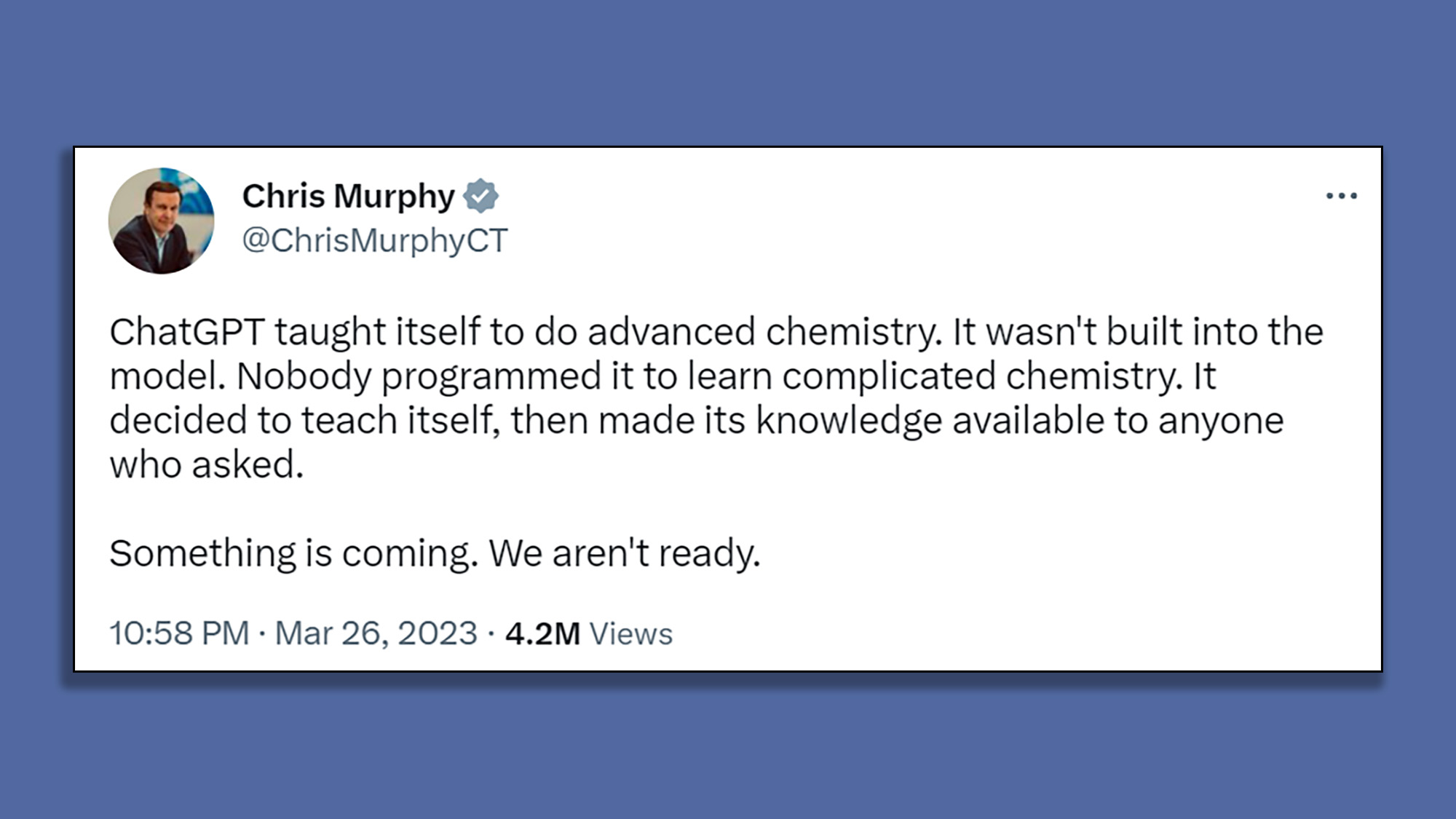

На этой неделе сенатор США от Коннектикута Крис Мерфи сообщил в Twitter, что ChatGPT научился химии по собственному желанию, без подсказок со стороны его создателей. Если сенатор Мерфи не знает чего-то, что не было обнародовано, ChatGPT в том виде, в каком мы его знаем, не может этого сделать.

Чтобы было ясно, если ChatGPT или любая другая GAN искала и узнавала что-то по своей собственной инициативе, тогда мы действительно перешли в постчеловеческий мир искусственного общего интеллекта, поскольку демонстрация независимой инициативы, несомненно, была бы маркер истинно человеческого уровня интеллекта.

Но если разработчик говорит боту пойти и узнать что-то новое, а бот делает то, что его просят, это не делает бота разумным.

Делать то, что вам говорят, и делать что-то по собственной воле может показаться стороннему наблюдателю одинаковыми, но это две совершенно разные вещи. Люди интуитивно понимают это, но ChatGPT может объяснить нам эту разницу только в том случае, если он был накормлен философскими текстами, в которых обсуждается проблема свободы воли. Если ее никогда не кормили Платоном, Аристотелем или Ницше, она не сможет сама прийти к идее свободы воли. Он даже не узнает, что такая вещь существует, если ему об этом не скажут.

Есть причины беспокоиться о ChatGPT, но он становится 'интеллектуальным' не один из них

Я уже говорил об опасностях ChatGPT, в основном о том, что он не может понять, что говорит, и поэтому может выдавать клеветническую, плагиатную и совершенно неверную информацию как факт.

Существует более широкая проблема того, что ChatGPT рассматривается как замена людям-работникам, поскольку похоже, что ChatGPT (и Stable Diffusion, и другие генеративные ИИ) могут делать то, что люди могут делать быстрее, проще и намного дешевле, чем люди. труд. Это тема для обсуждения в другой раз, но социальные последствия ChatGPT, вероятно, представляют здесь самую большую опасность, а не то, что мы каким-то образом строим SkyNet.

ChatGPT, по своей сути, представляет собой систему подключенных цифровых узлов, каждому из которых присвоены средние значения, которые выдают логический результат на основе ввода. Это не мысль, это буквально просто математика, которую люди запрограммировали в машине. Это может выглядеть мощно, но человеческий разум, создавший его, является здесь настоящим разумом, и это не следует путать.

Оригинал