NVIDIA повышает производительность вывода LLM с помощью новой библиотеки программного обеспечения TensorRT-LLM

9 сентября 2023 г.В то время как такие компании, как d-Matrix, вторгаются на прибыльный рынок искусственного интеллекта с желанной инфраструктурой вывода, лидер в области искусственного интеллекта NVIDIA сегодня анонсировала программное обеспечение TensorRT-LLM, библиотеку технологии вывода LLM, предназначенную для ускорения обработки вывода ИИ.

Перейти к:

- Что такое TensorRT-LLM?

Как TensorRT-LLM повышает производительность графических процессоров NVIDIA

План NVIDIA по снижению совокупной стоимости владения ИИ

Что такое TensorRT-LLM?

TensorRT-LLM — это библиотека с открытым исходным кодом, работающая на графических процессорах NVIDIA Tensor Core. Он предназначен для того, чтобы дать разработчикам возможность экспериментировать с созданием новых больших языковых моделей, которые являются основой генеративного искусственного интеллекта, такого как ChatGPT.

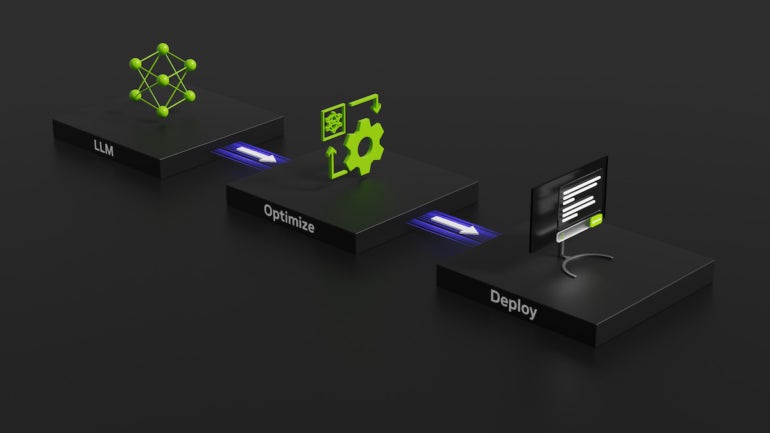

В частности, TensorRT-LLM охватывает умозаключение — усовершенствование обучения ИИ или способ, которым система учится связывать концепции и делать прогнозы, — а также определение, оптимизацию и выполнение LLM. По словам NVIDIA, цель TensorRT-LLM — ускорить выполнение вывода на графических процессорах NVIDIA.

TensorRT-LLM будет использоваться для создания версий современных тяжелых LLM, таких как Meta Llama 2, OpenAI GPT-2 и GPT-3, Falcon, Mosaic MPT, BLOOM и других.

Для этого TensorRT-LLM включает в себя компилятор глубокого обучения TensorRT, оптимизированные ядра, предварительную и постобработку, связь с несколькими графическими процессорами и несколькими узлами, а также интерфейс прикладного программирования Python с открытым исходным кодом.

NVIDIA отмечает, что отчасти привлекательность заключается в том, что разработчикам не нужны глубокие знания C++ или NVIDIA CUDA для работы с TensorRT-LLM.

ПОСМОТРЕТЬ: Microsoft предлагает бесплатные курсы для людей, которые хотят научиться применять генеративный искусственный интеллект в своем бизнесе. (Техреспублик)

«TensorRT-LLM прост в использовании; оснащенный функциями потоковой передачи токенов, пакетной обработки в реальном времени, внимания к страницам, квантования и многого другого; и эффективен», — рассказал NVIDIA в пресс-релизе Навин Рао, вице-президент по разработке Databricks. «Он обеспечивает самую современную производительность для обслуживания LLM с использованием графических процессоров NVIDIA и позволяет нам экономить средства для наших клиентов».

Databricks была среди компаний, первыми присмотревшихся к TensorRT-LLM.

Ранний доступ к TensorRT-LLM теперь доступен для людей, которые подписались на программу разработчиков NVIDIA. NVIDIA заявляет, что он будет доступен для более широкого выпуска «в ближайшие недели», согласно первоначальному пресс-релизу.

Как TensorRT-LLM повышает производительность графических процессоров NVIDIA

По словам NVIDIA, LLM, выполняющие обобщение статей, делают это быстрее на TensorRT-LLM и графическом процессоре NVIDIA H100 по сравнению с той же задачей на чипе NVIDIA A100 предыдущего поколения без библиотеки LLM. Только с H100 производительность вывода GPT-J 6B LLM выросла в 4 раза. Программное обеспечение TensorRT-LLM улучшило ситуацию в 8 раз.

В частности, вывод можно сделать быстро, поскольку TensorRT-LLM использует метод разделения различных весовых матриц между устройствами. (Взвешивание показывает модели ИИ, какие цифровые нейроны должны быть связаны друг с другом.) Этот метод, известный как тензорный параллелизм, означает, что вывод может выполняться параллельно на нескольких графических процессорах и на нескольких серверах одновременно.

По словам NVIDIA, пакетная обработка в реальном времени повышает эффективность вывода. Проще говоря, готовые пакеты сгенерированного текста могут создаваться по одному, а не все сразу. Пакетная обработка в реальном времени и другие оптимизации предназначены для улучшения использования графического процессора и снижения общей стоимости владения.

План NVIDIA по снижению совокупной стоимости владения ИИ

Использование LLM стоит дорого. Фактически, по мнению NVIDIA, программы LLM меняют то, как центры обработки данных и обучение искусственному интеллекту вписываются в баланс компании. Идея TensorRT-LLM заключается в том, что компании смогут создавать сложный генеративный ИИ без резкого роста совокупной стоимости владения.

Оригинал