HPE Discover 2023: GreenLake выходит на рынок ИИ с облачным сервисом LLM

21 июня 2023 г.Новый облачный сервис для суперкомпьютеров GreenLake для больших языковых моделей будет доступен в США в конце 2023 или начале 2024 года, сообщила Hewlett Packard Enterprise на HPE Discover во вторник. GreenLake для LLM позволит предприятиям обучать, настраивать и развертывать крупномасштабный искусственный интеллект, который является частным для каждого отдельного бизнеса.

GreenLake для LLM будет доступен европейским клиентам после выпуска в США с ожидаемым окном выпуска в начале 2024 года.

Перейти к:

- HPE сотрудничает со стартапом по разработке программного обеспечения для искусственного интеллекта Aleph Alpha

Суперкомпьютеры HPE Cray XD обеспечивают производительность корпоративного ИИ

Получение большей мощности из возобновляемых источников энергии

Альтернативы HPE GreenLake для LLM

HPE сотрудничает со стартапом по разработке программного обеспечения для искусственного интеллекта Aleph Alpha

«Искусственный интеллект переживает переломный момент, и в HPE мы наблюдаем спрос со стороны различных заказчиков, которые начинают использовать генеративный ИИ, — сказал Джастин Хотард, исполнительный вице-президент и генеральный менеджер HPC & AI Business Group и Hewlett Packard Labs, в ходе виртуальной презентации. .

GreenLake для LLM работает на архитектуре с искусственным интеллектом, охватывающей сотни или тысячи процессоров или графических процессоров, в зависимости от рабочей нагрузки. По словам HPE, эта гибкость в рамках одного предложения архитектуры с собственным ИИ делает его более эффективным, чем облачные варианты общего назначения, которые выполняют несколько рабочих нагрузок параллельно. GreenLake для LLM был создан в партнерстве с Aleph Alpha, немецким стартапом в области искусственного интеллекта, который предоставил предварительно обученный LLM под названием Luminous. Luminous LLM может работать на английском, французском, немецком, итальянском и испанском языках и может использовать текст и изображения для прогнозирования.

Сотрудничество было двусторонним: в первую очередь Aleph Alpha использовала инфраструктуру HPE для обучения Luminous.

«Используя суперкомпьютеры HPE и программное обеспечение для искусственного интеллекта, мы эффективно и быстро обучили Luminous, — сказал Йонас Андрулис, основатель и генеральный директор Aleph Alpha, в пресс-релизе. «Мы гордимся тем, что являемся партнером по запуску HPE GreenLake для крупноязыковых моделей, и мы с нетерпением ждем расширения нашего сотрудничества с HPE, чтобы распространить Luminous на облако и предложить его как услугу нашим конечным клиентам для запуска новых приложений для деловые и исследовательские инициативы».

Первоначальный запуск будет включать в себя набор моделей с открытым исходным кодом и проприетарных моделей для переобучения или тонкой настройки. В будущем HPE рассчитывает предоставить ИИ, специализированный для задач, связанных с моделированием климата, здравоохранением, финансами, производством и транспортом.

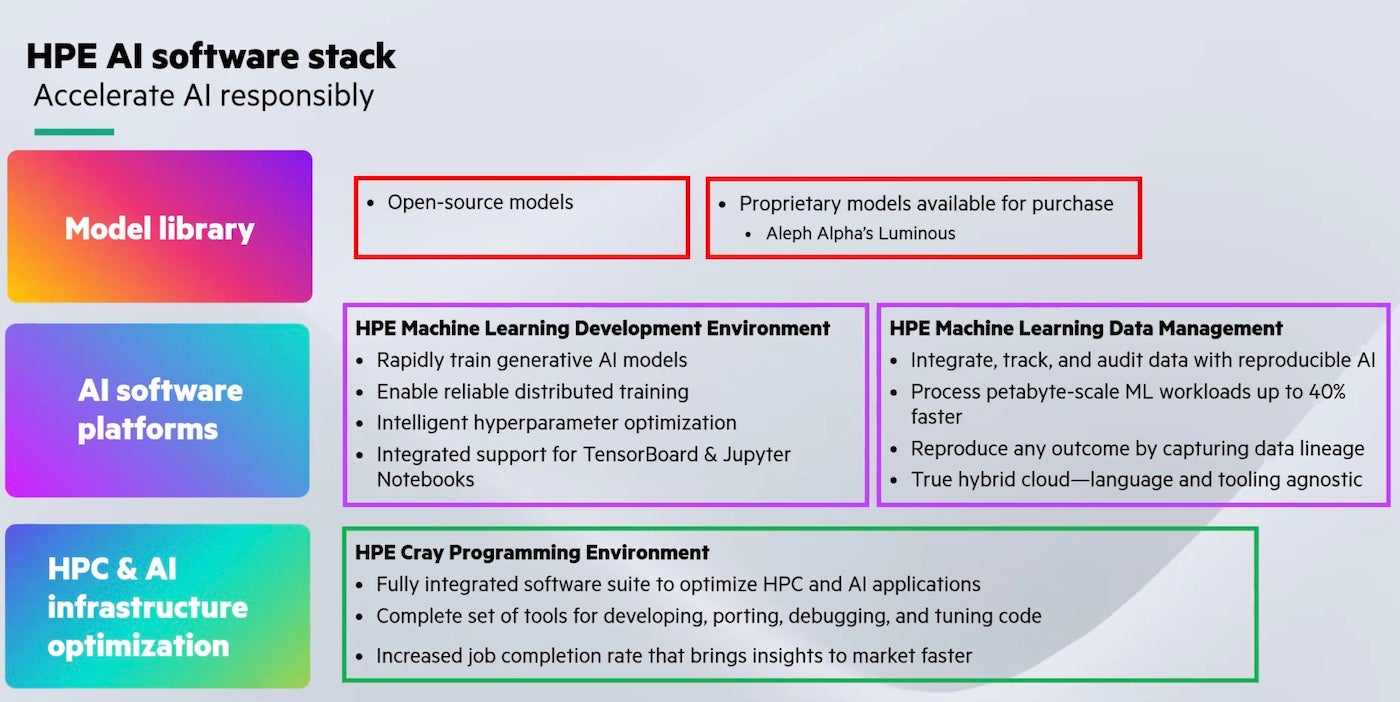

На данный момент GreenLake для LLM будет частью общего программного стека HPE для искусственного интеллекта (рис. A), который включает в себя модель Luminous, программы разработки машинного обучения, управления данными и разработки, а также среду программирования Cray.

Рисунок А

Суперкомпьютеры HPE Cray XD обеспечивают производительность корпоративного ИИ

GreenLake для LLM работает на суперкомпьютерах HPE Cray XD и графических процессорах NVIDIA H100. Суперкомпьютер и среда программирования HPE Cray позволяют разработчикам выполнять анализ данных, задачи на естественном языке и другую работу с высокопроизводительными вычислениями и приложениями ИИ без необходимости запуска собственного оборудования, что может быть дорогостоящим и требует специальных знаний для суперкомпьютеров.

Хотард отметил во время презентации, что крупномасштабное корпоративное производство для ИИ требует огромных ресурсов производительности, квалифицированных людей, а также безопасности и доверия.

ПОСМОТРЕТЬ: NVIDIA предлагает аренду ИИ на своем суперкомпьютере DGX.

Получение большей мощности из возобновляемых источников энергии

Используя колокейшн, HPE стремится обеспечить свои суперкомпьютеры полностью возобновляемой энергией. HPE работает со специалистом по вычислительным центрам QScale в Северной Америке над конструкцией, созданной специально для этой цели.

«Цель всех наших облачных развертываний — предоставить нашим клиентам 100% углеродно-нейтральное предложение», — сказал Хотард. «Одним из преимуществ жидкостного охлаждения является то, что вы можете использовать сточные воды, нагретую воду, и использовать их повторно. У нас есть это в других суперкомпьютерных установках, и мы также используем этот опыт в этом облачном развертывании».

Альтернативы HPE GreenLake для LLM

Другие облачные сервисы для запуска LLM включают NeMo от NVIDIA (который в настоящее время находится в раннем доступе), Amazon Bedrock и Oracle Cloud Infrastructure.

Хотард отметил в презентации, что GreenLake для HPE будет дополнением, а не заменой крупных облачных сервисов, таких как AWS и Google Cloud Platform.

«Мы можем и намерены интегрироваться с публичным облаком. Мы рассматриваем это как бесплатное предложение; мы не рассматриваем это как конкурента», — сказал он.

Оригинал