Дипфейки с использованием искусственного интеллекта становятся риском для организаций Азиатско-Тихоокеанского региона

5 апреля 2024 г.Совсем недавно дипфейки с использованием искусственного интеллекта не были в зоне риска организаций, но в 2024 году они поднимаются в рейтинге. Поскольку дипфейки с использованием искусственного интеллекта способны вызвать что угодно — от падения цен на акции до потери доверия к бренду из-за дезинформации, они, вероятно, в течение некоторого времени будут представлять собой риск.

Роберт Хубер, директор по безопасности и руководитель исследования в фирме по кибербезопасности Tenable, заявил в интервью TechRepublic, что дипфейки ИИ могут быть использованы целым рядом злоумышленников. Хотя инструменты обнаружения все еще совершенствуются, предприятия Азиатско-Тихоокеанского региона могут подготовиться, добавив дипфейки в свои оценки рисков и лучше защитив собственный контент.

В конечном итоге, более надежная защита организаций станет возможной, когда международные нормы сблизятся вокруг ИИ. Хубер призвал крупных игроков технологических платформ активнее и более четко идентифицировать контент, созданный искусственным интеллектом, вместо того, чтобы оставлять это на усмотрение отдельных пользователей, не являющихся экспертами.

Дипфейки с использованием искусственного интеллекта представляют собой растущий риск для общества и бизнеса

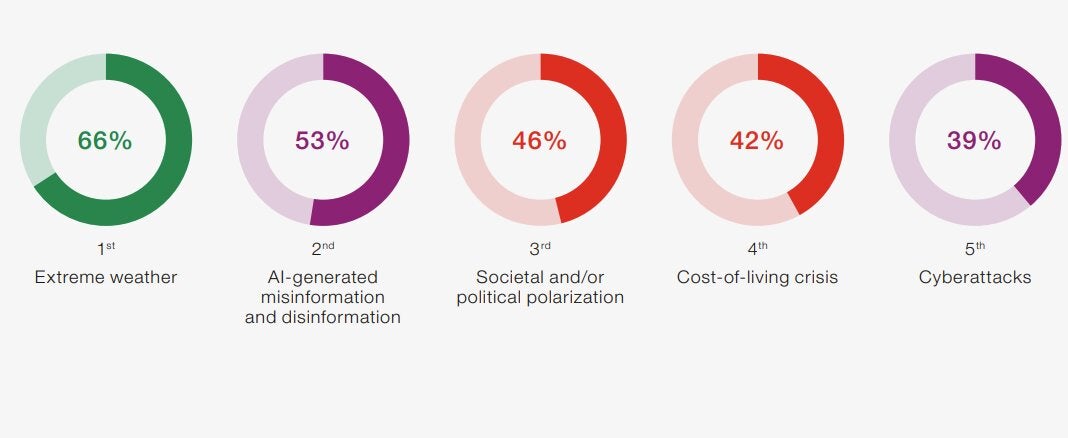

Риск дезинформации и дезинформации, создаваемых ИИ, становится глобальным риском. В 2024 году, после запуска волны генеративных инструментов искусственного интеллекта в 2023 году, эта категория рисков в целом заняла второе место по величине в отчете Всемирного экономического форума о глобальных рисках за 2024 год (рисунок A).

Рисунок А

Более половины (53%) респондентов, представляющих бизнес, научные круги, правительство и гражданское общество, назвали риском дезинформацию и дезинформацию, создаваемую ИИ, включая дипфейки. Дезинформация также была названа самым большим фактором риска в течение следующих двух лет (рис. B).

Рисунок Б

Предприятия не спешат учитывать риск дипфейков с использованием ИИ. Например, в глобальном исследовании управления рисками Aon это не упоминается, хотя организации обеспокоены перерывами в бизнесе или ущербом для их бренда и репутации, который может быть вызван искусственным интеллектом.

Хубер сказал, что риск дипфейков ИИ все еще существует, и он меняется по мере того, как изменения в ИИ происходят быстрыми темпами. Однако он сказал, что это риск, который организации Азиатско-Тихоокеанского региона должны учитывать. «Это не обязательно киберриск. Это корпоративный риск», — сказал он.

Дипфейки с использованием искусственного интеллекта предоставляют новый инструмент практически любому злоумышленнику

Ожидается, что дипфейки с использованием искусственного интеллекта станут еще одним вариантом, который любой противник или субъект угроз сможет использовать для достижения своих целей. Хубер сказал, что это могут быть национальные государства с геополитическими целями и группы активистов с идеалистическими программами, мотивация которых включает финансовую выгоду и влияние.

«Здесь вы будете использовать весь спектр: от групп национальных государств до групп, заботящихся об окружающей среде, до хакеров, которые просто хотят монетизировать депфейки. Я думаю, что это еще один инструмент в арсенале любого злоумышленника», — объяснил Хубер.

СМОТРИТЕ: Как генеративный ИИ может увеличить глобальную угрозу со стороны программ-вымогателей

Низкая стоимость дипфейков означает низкие барьеры для входа злоумышленников.

Простота использования инструментов ИИ и низкая стоимость производства материалов ИИ означают, что злоумышленникам мало что мешает использовать новые инструменты. Хубер сказал, что одним из отличий от прошлого является уровень качества, который теперь доступен злоумышленникам.

«Несколько лет назад [стоимостной] барьер входа был низким, но и качество было низким», — сказал Хубер. «Сейчас планка все еще низкая, но [с генеративным ИИ] качество значительно улучшается. Так что большинству людей идентифицировать дипфейк самостоятельно, без дополнительных подсказок, становится все труднее».

Каковы риски для организаций от дипфейков с использованием искусственного интеллекта?

По словам Хубера, риски дипфейков с использованием искусственного интеллекта «настолько высоки, что они не включены в программы оценки организационных рисков Азиатско-Тихоокеанского региона». Однако, ссылаясь на недавнюю спонсируемую государством кибератаку на Microsoft, о которой сообщила сама Microsoft, он предложил людям задаться вопросом: а что, если это был дипфейк?

«Будь то дезинформация или влияние, Microsoft претендует на крупные контракты для своего предприятия с различными правительствами и причинами по всему миру. Это будет говорить о надежности такого предприятия, как Microsoft, или применимо к любой крупной технологической организации».

Потеря корпоративных контрактов

Коммерческие предприятия любого типа могут пострадать от дипфейковых материалов ИИ. Например, производство дезинформации может вызвать вопросы или потерю контрактов по всему миру или спровоцировать социальные опасения или реакцию на организацию, которая может нанести ущерб ее перспективам.

Риски физической безопасности

Дипфейки с использованием искусственного интеллекта могут добавить новое измерение к ключевому риску разрушения бизнеса. Например, дезинформация, полученная от искусственного интеллекта, может вызвать бунт или даже ощущение бунта, создавая либо опасность для физических лиц или операций, либо просто ощущение опасности.

Влияние бренда и репутации

Forrester опубликовал список потенциальных мошенничеств с дипфейками. К ним относятся риски для репутации и бренда организации или опыта сотрудников и кадров. Одним из рисков было усиление, когда дипфейки ИИ используются для распространения других дипфейков ИИ, охватывая более широкую аудиторию.

Финансовые последствия

Финансовые риски включают в себя возможность использовать дипфейки ИИ для манипулирования ценами на акции и риск финансового мошенничества. Недавно финансового сотрудника транснациональной компании в Гонконге обманом заставили заплатить преступникам 25 миллионов долларов США (40 миллионов австралийских долларов) после того, как они использовали сложную аферу с искусственным интеллектом, чтобы выдать себя за финансового директора фирмы во время видеоконференции.

Индивидуальное суждение не является фальшивым решением для организаций.

Большой проблемой для организаций Азиатско-Тихоокеанского региона является то, что обнаружение дипфейков с помощью ИИ сложно для всех. В то время как регуляторы и технологические платформы приспосабливаются к росту ИИ, большая часть ответственности за выявление дипфейков ложится на самих отдельных пользователей, а не на посредников.

Это может привести к тому, что убеждения отдельных людей и толп повлияют на организации. Людей просят решить в режиме реального времени, может ли разрушительная история о бренде или сотруднике быть правдивой или поддельной в среде, которая может включать дезинформацию в СМИ и социальных сетях.

Отдельные пользователи не способны отличить факты от вымысла.

Хубер сказал, что ожидать, что люди смогут распознать, что является дипфейком, созданным ИИ, а что нет, «проблемно». В настоящее время дипфейки с использованием искусственного интеллекта может быть сложно распознать даже техническим специалистам, утверждает он, и людям с небольшим опытом выявления дипфейков с использованием искусственного интеллекта придется столкнуться с трудностями.

«Это все равно, что сказать: «Мы собираемся научить всех понимать кибербезопасность». ACSC (Австралийский центр кибербезопасности) выпускает множество замечательных руководств по кибербезопасности, но кто действительно их читает, кроме людей, которые на самом деле в сфере кибербезопасности?» он спросил.

Предвзятость также является фактором. «Если вы просматриваете важный для вас материал, вы приносите с собой предвзятость; вы с меньшей вероятностью сосредоточитесь на нюансах движений или жестов, а также на том, является ли изображение трехмерным. Вы не используете свои паучьи чувства и не ищете аномалии, если это контент, который вас интересует».

Инструменты для обнаружения дипфейков с использованием искусственного интеллекта догоняют

Технологические компании стремятся предоставить инструменты для удовлетворения растущего числа дипфейков с использованием искусственного интеллекта. Например, инструмент Intel FakeCatcher, работающий в реальном времени, предназначен для выявления дипфейков путем оценки кровообращения людей в видеороликах с использованием видеопикселей, а также для выявления фейков по принципу «то, что делает нас людьми».

Хубер сказал, что возможности инструментов для обнаружения и идентификации дипфейков с использованием искусственного интеллекта все еще развиваются. Изучив некоторые инструменты, доступные на рынке, он сказал, что на данный момент он не может ничего особенно порекомендовать, потому что «пространство движется слишком быстро».

Что поможет организациям бороться с рисками дипфейков, связанных с ИИ?

По словам Хубера, рост количества дипфейков с использованием искусственного интеллекта, скорее всего, приведет к игре в кошки-мышки между злоумышленниками, создающими дипфейки, и теми, кто пытается их обнаружить и помешать. По этой причине инструменты и возможности, помогающие обнаруживать дипфейки ИИ, скорее всего, быстро изменятся, поскольку «гонка вооружений» порождает войну за реальность.

В их распоряжении могут быть некоторые оборонные организации.

Формирование международных норм регулирования ИИ

Австралия — одна из юрисдикций, которая рассматривает возможность регулирования контента ИИ с помощью таких мер, как использование водяных знаков. По мере того, как другие юрисдикции по всему миру приближаются к консенсусу по управлению ИИ, вероятно, произойдет сближение подходов в отношении лучших практических подходов для поддержки лучшей идентификации контента ИИ.

Хубер сказал, что, хотя это очень важно, существуют классы игроков, которые не будут следовать международным нормам. «Должно быть неявное понимание того, что все равно найдутся люди, которые будут это делать, независимо от того, какие правила мы введем или как мы попытаемся свести это к минимуму».

СМОТРИТЕ: Краткое изложение новых правил ЕС, регулирующих искусственный интеллект

Крупные технологические платформы, выявляющие дипфейки с использованием искусственного интеллекта

Ключевым шагом для крупных социальных сетей и технологических платформ, таких как Meta и Google, было бы более эффективно бороться с дипфейковым контентом, созданным искусственным интеллектом, и более четко идентифицировать его для пользователей на своих платформах. Взятие на себя большей ответственности означало бы, что конечным пользователям, не являющимся экспертами, таким как организации, сотрудники и общественность, придется меньше работать, пытаясь определить, является ли что-то дипфейком.

Хубер сказал, что это также поможет ИТ-командам. Наличие крупных технологических платформ, которые на передовой выявляют дипфейки с использованием искусственного интеллекта и вооружают пользователей дополнительной информацией или инструментами, отнимет у организаций эту задачу; потребуется меньше инвестиций в ИТ для оплаты и управления инструментами обнаружения дипфейков, а также для выделения ресурсов безопасности для управления ими.

Добавление дипфейков искусственного интеллекта в оценку рисков

Организациям Азиатско-Тихоокеанского региона, возможно, вскоре придется рассмотреть возможность включения рисков, связанных с дипфейками ИИ, в регулярные процедуры оценки рисков. Например, Хубер сказал, что организациям, возможно, придется гораздо более активно контролировать и защищать контент, который организации производят как внутри, так и снаружи, а также документировать эти меры для третьих сторон.

«Большинство зрелых охранных компаний проводят сторонние оценки рисков поставщиков. Я никогда не видел вопросов, связанных с тем, как они защищают свой цифровой контент», — сказал он. Хубер ожидает, что сторонние оценки рисков, проводимые технологическими компаниями, вскоре могут нуждаться в включении вопросов, касающихся минимизации рисков, возникающих в результате дипфейков.

Оригинал